浙大团队使用模仿放松的强化学习法子,优化机器人的高速四足运动

腿式机器人的快速稳定运动涉及苛刻且矛盾的要求,特别是快速控制频率和精确的动力学模型。受益于神经网络的通用逼近能力和离线优化,强化学习已被用于解决有腿机器人运动中的各类具有挑战性的问题;然而,四足机器人的最优控制需要优化多个目标,如保持平衡、提高效率、实现周期性步态和服从命令等。这些目标不能总是同时实现,尤其是在高速情况下。

在这里,浙江大学团队介绍了一种模仿松弛强化学习 (irrl) 方法来分阶段优化目标。为了弥合模拟与现实之间的差距,研究人员进一步将随机稳定性的概念引入系统稳健性分析中。状态空间熵递减率是一个定额指标,可以敏锐地捕捉到倍周期分岔的发生和可能出现的混沌。通过在训练和随机稳定性分析中使用 irrl,研究人员证明 mit-minicheetah 类机器人的稳定运行速度为 5.0 m s^–1。

该研究以「high-speed quadrupedal locomotion by imitation-relaxation reinforcement learning」为题,于 2022 年 十二 月 14 日发布在《nature machine intelligence》。

提高敏捷性,达到并超越动物的最大速度对于有腿机器人研究来说是一项挑战。对于动物来说,它们卓越的机动性是灵巧的骨骼-肌肉系统和搀杂的中央感觉-运动控制结构的内在结果。这激发了新的设计理念和新颖的控制算法,以实现与自然对应物相媲美的性能。

下图显示了四足动物的最大奔跑速度与体重的关系。实线勾勒出最大速度与体重的一般比例模型。与同等重量的最先进机器人相比,四足动物显然具有压倒性的优越机动性,尽管后者近年来取得了显著成就。另一方面,就功率密度和带宽而言,致动器通常优于肌肉。生物肌肉的典型功率密度为 300 w kg^-1,而低本钱模块化电机——比如安装在 mit-minicheetah 四足机器人上的那些——可以实现高达 520w kg^-1 的功率密度,同时在 17 n m 时保持约 1.5khz 的高扭矩带宽。比较表明,当前的机器人控制方案不足以获得人造执行器的全部功率。

最近的一项研究表明,通过提高控制器的频率和动力学模型的精度,mit-minicheetah 机器人的最高速度可以提高到 3.7 m s^–1,比以前的记录高出约 50%。尽管如此,要赶上动物的表现,仍有很大的空间可以通过开发更先进的控制算法来提高敏捷性。

高机动性的需求对运动控制器提出了各种挑战。首先,随着机器人速度的增加,有必要重新检查动力学模型的准确性。质心动力学模型已广泛应用于四足机器人中低速平衡控制。简化的动力学模型降低了机载计算成本,因此可以提高控制频率以实现优化的整体性能。更高的速度需要更快的准周期摆动腿。更高的加速度会导致来自机电的腿和转子的不可忽略的惯性力,这在过于简化的质心动力学中没有得到充分考虑。更准确的模型将导致更高维度的问题,超出了实时控制的机载计算能力。其次,更高的速度减少了机器人脚与地面的接触时间。同时,接触力的变化更加剧烈。因此,保持机器人的平衡需要更高的控制频率。

为了提高计算效率,模型预测控制 (mpc) 采用了新策略,例如塑造奖励函数和基于变化的线性化技术。尽管做出了这些努力,但很难充分考虑全身动力学。同时,在在线控制中选择全身脉冲控制等层次方案作为组合解决方案。此外,高速运动要求电机同时输出大扭矩和高速度,而高速时的反电动势将大大降低扭矩输出能力。这将给控制器设计带来进一步的非线性约束。

基于在线优化的控制方法难以同时应对苛刻的精度和频率要求。另一种方法是使用更高效的端到端控制器,可以通过充分考虑复杂的动力学模子来离线优化。通过这种方式,机载控制频率与机器人动力学的高精度时间成本脱钩。同时,执行器的非线性行为也可以在离线优化中考虑。

强化学习 (rl) 有望通过使用神经网络制定运动控制器来克服过去基于模型的方法的局限性。使用专用于高维混合非线性动态系统的高效模拟器离线执行优化。基于物理的动画角色的高度动态杂技控制已经取得了巨大的优势,启发了机器人控制。最近已经证明,rl 可以解决物理腿机器人运动中的一系列具备挑战性的问题;例如,在阶梯状地形和动态自然环境中的稳健运动、跌倒恢复以及步态计划和切换。一些实践表明,rl 在四足机器人的高机动控制方面与mpc不相上下。然而,模拟与现实之间的差距仍然存在。基于 rl 的控制器的成功部署在很大程度上依赖于经验和参数调整。

除了计算效率和模型精度之外,稳定性和稳健性是设计可执行高动态运动的控制器的其他主要关注点。由于动力学、控制器和模棱两可的机器人与环境相互作用等复杂的因素,它们很难评估。从时间序列计算出的最大 lyapunov 指数是一种广泛使用的稳定性度量,但最大 lyapunov 指数与实际稳定性之间的关系对于有腿机器人来说是微弱的。为了避免机器人动力学和控制器的复杂性,利用生存力理论通过遍历简化模型系统的状态-动作空间来量化稳健性。不幸的是,对于快速运动,简化模型与真实动力学有很大不同。在实践中,整体稳定性是通过有腿机器人的推动-恢复行为粗略估计的。由于所涉及的因素不可分割且难以处理,因此稳定性评估基本上是定性的,并没有提供太多关于目标导向改进的有用信息。

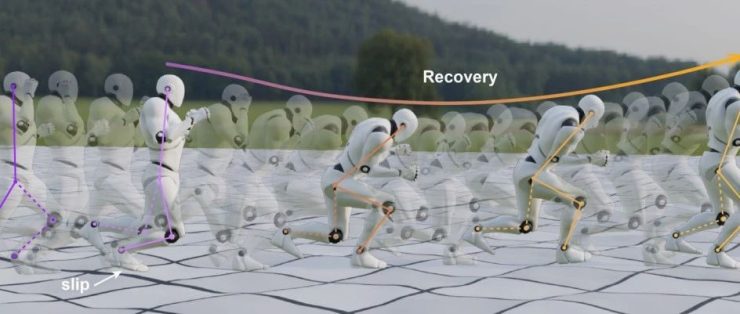

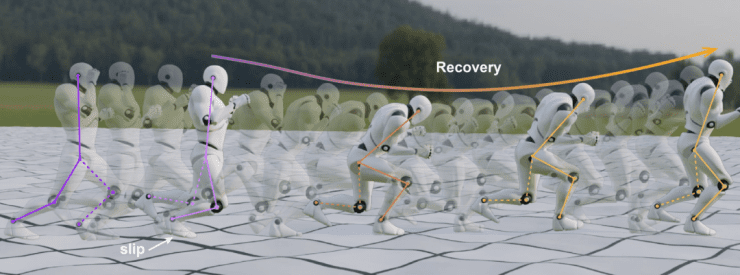

在这里,浙江大学团队提出了一种系统的学习范式和基于 rl 的控制器的稳健性评估,该控制器专用于机器人的稳定高速运动。为了避免不真实的行为,在训练过程中提供了参考轨迹作为指导。然而,性能对高速运行的参考轨迹之间的微小差异很敏感。同时,没有适合所有速度范围的单一理想参考轨迹。为了减轻这种严格的请求,研究人员设计了一个经过调整的两步训练过程。在第一步中,控制器通过模仿学习进行训练,以便可以近似地再现运动学参考轨迹。随后是松弛步骤,通过部分消除非理想参考轨迹的影响来适应特定的机器人动力学。值得注意的是,模仿和松弛强化学习(irrl)过程是降低训练成本和在高维参数空间中找到最优解的关键。

图示:irrl 方法的概念和考证。(来源:论文)

对于机器人系统的随机性,熵稳定性是扰动后恢复极限循环运动能力的一种可行措施。机器人状态分布将缩小到极限圆,导致随机稳定系统状态空间的熵减少。否则,倍周期和混沌系统的状态熵会增加。熵递减率是动态系统稳定性的一个关键指标。rl 控制器的随机稳定性很简单评估,这本质上是一个随机问题,并基于对动作空间的采样进行优化。借助并行的大规模模拟,可以收集一组在各种扰动下的轨迹,从而给出熵计算的演化状态分布。这样,系统延迟、地面摩擦和特定步态的影响可以单独考虑。

通过在训练和随机稳定性分析中使用 IRRL,控制器和机器人硬件都得到了相应的改进。研究人员证明了 MIT-MiniCheetah 类机器人的稳定运行速度为 5.0 m s^–1,与 MIT-MiniCheetah 机器人达到的最高速度(3.7 m s^–1)相比提高了 35%。无量纲弗劳德数为 8.5,高于此前由专门跑步的四足机器人 MIT-Cheetah II 创下的 7.1 的记录。

受益于神经网络的通用逼近能力和离线优化,RL 方法可以缓解动态模型精度和控制频率之间长期存在的冲突。这为充分探索硬件追赶甚至超越动物敏捷性的潜力提供了一条可行的途径。不幸的是,由于多个目标之间的冲突,局部极值严重限制了 RL 的有效性。Easy-to-hard learning是解决这个问题的成熟策略。由于模拟奖励的单峰性质,如参数超平面上的累积奖励表面所示,局部极值通过两步 IRRL 方法绕行。

图示:双足机器人在地形上打滑后的压力响应。(来源:论文)

同时,连接运动模仿解和最优解的超直线上的奖励函数是光滑凸的,也保证了快速收敛。与无参考方法相比,关于 IRRL 的一个问题是参考轨迹可能会狭窄地限制解决方案空间。基于双足机器人意外的应力响应,研究人员认为松弛步骤能够消除参考的缺点并使控制器更适合特定的机器人动力学。值得注意的是,分割高维参数空间揭示了奖励函数的模糊性。希望这种方法可以为 RL 研究提供一种分析工具。

基于熵的稳定性和稳健性分析是这项工作成功部署的关键。熵减率可以灵敏地捕捉系统倍周期分岔和混沌的发生。这提供了一个新的控制器稳健性指标,有助于弥合仿真与现实之间的差距。对于当前存在,它被用作后验方法,因为熵计算是计算密集型的。在不久的将来,研究人员希望将其引入 RL 过程中,以寻找更稳定的控制器。

论文链接:https://www.nature.com/articles/s42256-022-00576-3

本文链接: https://www.yizhekk.com/0120256463.html